In Krisensituationen sind schnelle Informationsverarbeitung und effektive Kommunikation von entscheidender Bedeutung. Kilian Sprenkamp beleuchtet in der Kolumne DSI Insights auf Inside IT das Potenzial von Large Language Models (LLMs) wie GPT-4 für den öffentlichen Sektor, insbesondere in den Bereichen Flüchtlingshilfe und Propagandaerkennung. Er zeigt anhand konkreter Anwendungen, wie KI-gestützte Chatbots und Analysetools bereits heute in Krisenkontexten eingesetzt werden.

Autor: Kilian Sprenkamp

LLMs können in Krisensituationen bei der schnellen Informationsverarbeitung und effektiven Kommunikation helfen.

Flüchtlingshilfe

Erkennung von Propaganda

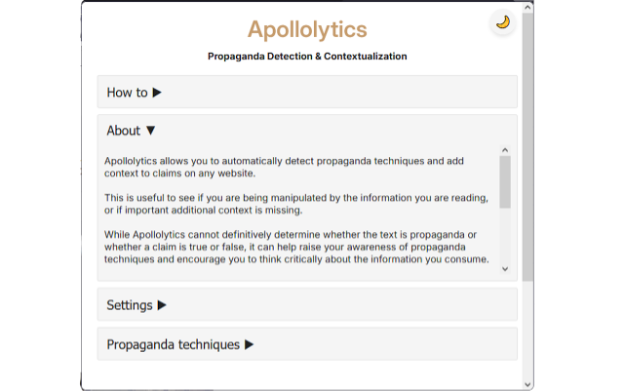

Apollolytics Browser-Erweiterung

Insights für den öffentlichen Sektor

- Kontext von LLMs: Der öffentliche Sektor kann LLMs durch die Verknüpfung mit externen Datenquellen verbessern. Dies ermöglicht genauere und kontextspezifischere Antworten, insbesondere in dynamischen Situationen wie Flüchtlingskrisen, indem aktuelle und relevante Informationen genutzt werden. Ähnlich stellt Apollolytics mehr Kontext bereit, wenn LLMs auf als Propaganda markierte Texte zugreifen und diese verarbeiten können.

- Wahl des LLM-Typs: Organisationen müssen entscheiden, ob sie Closed-Source-LLMs (z.Bsp.GPT von OpenAI) oder Open-Source-LLMs (z.Bsp. Llama von Meta) einsetzen wollen. Closed-Source-LLMs verfügen über umfangreiche Wissensbasen und sind einfach über APIs zugänglich. Im Gegensatz dazu bieten Open-Source-LLMs mehr Flexibilität und Anpassungsmöglichkeiten für spezifische Anwendungsfälle, erfordern jedoch eine eigene Hosting-Infrastruktur.

- Ethik im Kriseneinsatz: Es ist wichtig, ein Gleichgewicht zwischen den Vorteilen von LLMs und dem Schutz individueller Rechte zu finden. In Krisenzeiten muss die Dringlichkeit des Einsatzes von LLMs gegen den Datenschutz abgewogen werden. Beispielsweise entspricht die Nutzung von R2G der Datenschutz-Grundverordnung, wirft jedoch ethische Fragen auf.

Der Artikel bezieht sich auf die Projekte «Government as a Platform» (2. Projekt-Call) und «Propagandaerkennung mit AI» (1. Founder-Call). Kilian Sprenkamp arbeitet bei beiden Projekten mit.